随着大数据的发展,计算能力的提升,人工智能近两年迎来了新一轮的爆发。而人工智能的实现依赖三个要素:算法是核心,硬件和数据是基础,芯片就是硬件的最重要组成部分。它其实包括两个计算过程:1、训练(Train);2、应用(Inference)。

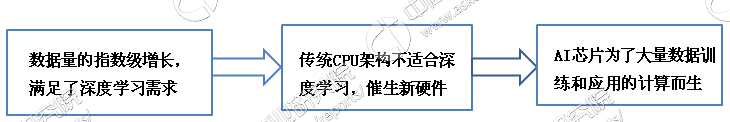

为什么需要人工智能芯片?神经网络算法应用的不断发展,使得传统的CPU已经无法负担几何级增长的计算量。深度学习作为机器学习的分支,是当前人工智能研究的主流方式。简单说就是用数学方法模拟人脑神经网络,用大量数据训练机器来模拟人脑学习过程,其本质是把传统算法问题转化为数据和计算问题。所以对底层基础芯片的要求也发生了根本性改变:人工智能芯片的设计目的不是为了执行指令,而是为了大量数据训练和应用的计算。

AI芯片的诞生之路

资料来源:公开资料整理

目前适合深度学习的人工智能芯片主要有GPU、FPGA、ASIC三种技术路线。三类芯片代表分别有英伟达(NVIDIA)的Tesla系列GPU、赛灵思(Xilinx)的FPGA和Google的TPU。GPU最先被引入深度学习,技术最为成熟;FPGA具有硬件可编程特点,性能出众但壁垒高。ASCI由于可定制、低成本是未来终端应用的趋势。

DPU

GPU使用SIMD(单指令多数据流)来让多个执行单元以同样的步伐来处理不同的数据,原本用于处理图像数据,但其离散化和分布式的特征,以及用矩阵运算替代布尔运算适合处理深度学习所需要的非线性离散数据。作为加速器的使用,可以实现深度学习算法。

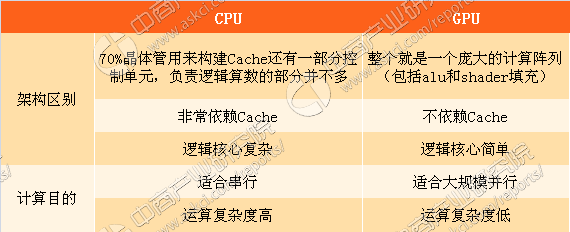

GPU由并行计算单元和控制单元以及存储单元构成GPU拥有大量的核(多达几千个核)和大量的高速内存,擅长做类似图像处理的并行计算,以矩阵的分布式形式来实现计算。同CPU不同的是,GPU的计算单元明显增多,特别适合大规模并行计算。

GPU与CPU的比较

资料来源:中商产业研究院

FPGA

FPGA是用于解决专用集成电路的一种方案。专用集成电路是为特定用户或特定电子系统制作的集成电路。人工智能算法所需要的复杂并行电路的设计思路适合用FPGA实现。FPGA计算芯片布满“逻辑单元阵列”,内部包括可配置逻辑模块,输入输出模块和内部连线三个部分,相互之间既可实现组合逻辑功能又可实现时序逻辑功能的独立基本逻辑单元。

FPGA相对于CPU与GPU有明显的能耗优势,主要有两个原因。首先,在FPGA中没有取指令与指令译码操作,在Intel的CPU里面,由于使用的是CISC架构,仅仅译码就占整个芯片能耗的50%;在GPU里面,取指令与译码也消耗了10%~20%的能耗。其次,FPGA的主频比CPU与GPU低很多,通常CPU与GPU都在1GHz到3GHz之间,而FPGA的主频一般在500MHz以下。如此大的频率差使得FPGA消耗的能耗远低于CPU与GPU。

ASIC

ASIC(专用定制芯片)是为实现特定要求而定制的芯片,具有功耗低、可靠性高、性能高、体积小等优点,但不可编程,可扩展性不及FPGA,尤其适合高性能/低功耗的移动端。

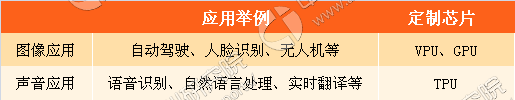

目前,VPU和TPU都是基于ASIC架构的设计。针对图像和语音这两方面的人工智能定制芯片,目前主要有专用于图像处理的VPU,以及针对语音识别的FAGA和TPU芯片。

图像应用和语音应用人工智能定制芯片

资料来源:中商产业研究院

如发现本站文章存在版权问题,烦请联系editor@askci.com我们将及时沟通与处理。

如发现本站文章存在版权问题,烦请联系editor@askci.com我们将及时沟通与处理。